pline,直接端到端输出,且可以按用户的 prompt 输出不同的格式如 Latex、Wd、Markdown。通过 LLM 极强的语言先验,这种架构还可以避免 OCR 中的易错字,比如“杠杆”和“杜杆”等, 对于模糊文档,也有望在语言先验的帮助下实现更强的 OCR 效果。

目前的多模态大模型几乎都是用 CLIP 作为 Vision Encoder 或者说视觉词表。确实,在 400M 图像文本对训练的 CLIP 有很强的视觉文本对齐能力,可以覆盖多数日常任务下的图像编码。但是对于密集和细粒度感知任务,比如文档级别的 OCR、Chart 理解,特别是在非英文场景,CLIP 表现出了明显的编码低效和 out-of-vocabulary问题。

受语言的 LLMs 启发,纯 NLP 大模型(如 LLaMA)从英文到中文(外语)时因为原始词表编码中文效率低,必须要扩大text 词表。那么对于现在基于 CLIP 视觉词表的多模大模型也是一样的,遇到 “foreign language image”,如一页论文密密麻麻的文字,很难高效地将图片 token 化k8凯发,Vary 提出就是解决这一问题,在不 overwrite 原有词表前提下,高效扩充视觉词表。

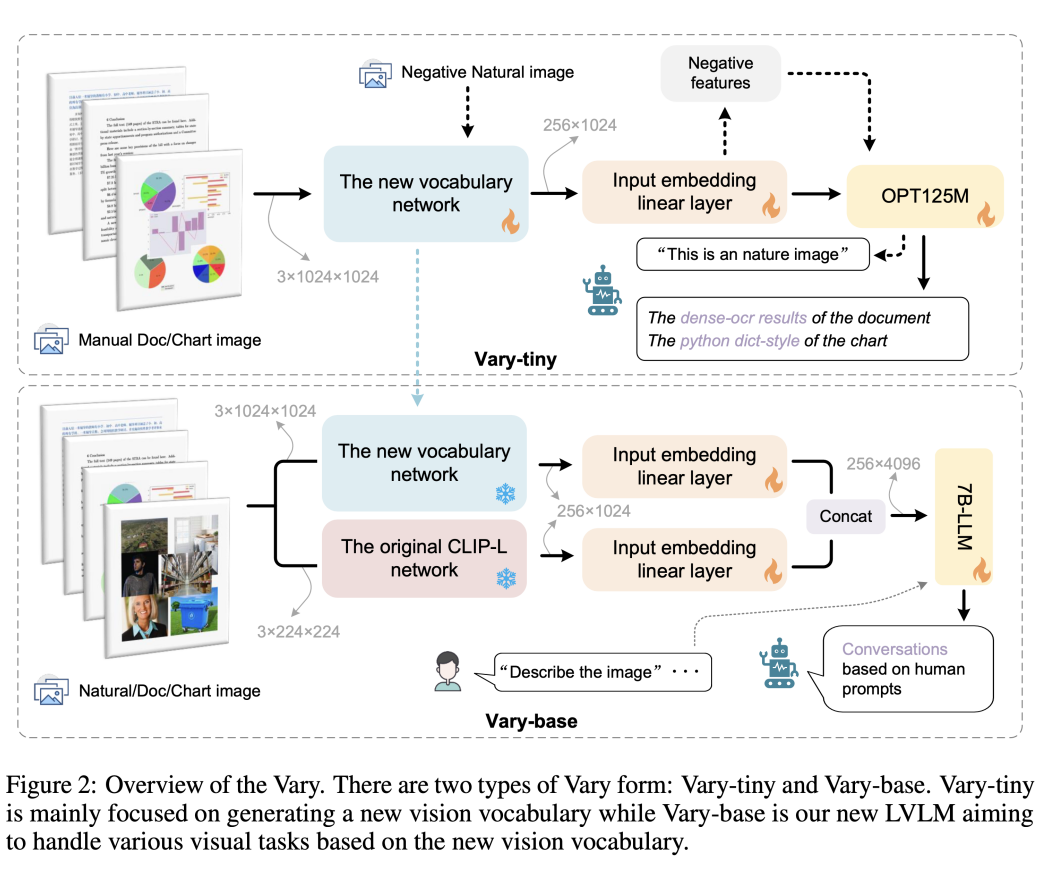

不同于现有方法直接用现成的 CLIP 词表,Vary 分两个阶段:第一阶段先用一个很小的 Decoder-only网络用自回归方式帮助产生一个强大的新视觉词表;然后在第二阶段融合新词表和 CLIP 词表,从而高效的训练多模大模型拥有新 feature。Vary 的训练方法和模型结构如下图:

通过在公开数据集以及渲染生成的文档图表等数据上训练,Vary 极大增强了细粒度的视觉感知能力。在保持 Vanilla 多模态能力的同时,激发出了端到端的中英文图片、公式截图和图表理解能力。

另外,原本可能需要几千 tokens 的页面内容,通过文档图片输入,信息被Vary压缩在了 256 个图像 tokens 中。这也为进一步的页面分析和总结提供了更多的想象空间。

目前,Vary 的代码和模型均已开源,还给出了供大家试玩的网页 demo。感兴趣的小伙伴可以去试试了~

原文标题:OCR终结了?旷视提出可以文档级OCR的多模态大模型框架Vary,支持中英文,已开源!

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。举报投诉物联网物联网+关注

原文标题:OCR终结了?旷视提出可以文档级OCR的多模态大模型框架Vary,支持中英文,已开源!

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

处理流程化实现 /

识别工具的效果,给大家分别讲讲两个工具的使用方法和对比效果。 1.准备 开始之前,你要确保

如何自动识别图片文字 /

Vitis AI Runtime,Vitis AI Library 有很多已经封装好的神经网络接口,直接拿来用即可。

、PDF 文件或图像中的文本转换成机器可识别的格式的技术。它在许多领域都有广泛的应用,例如

快速训练与优化 /

,“CPU” 的味道更重了 /

切换,这样有利于我们更加方便的进行设计,对于新手可能使用中文版本的较多,但是目前很多设计师习惯于使用

显示 /

使用指南(仅适用于万兴PDF专业版) /

OpenFlamingo,k8凯发作者使用公开数据集创建了各种视觉指令数据,包括视觉问答、图像字幕、视觉推理、文本

聊天机器人! /

PaddleSpeech 又带着新功能和大家见面了。本次更新,为开发者们带来了基于端到端语音识别

混合语音识别方案 /

实战教程 /

【国产FPGA+OMAPL138开发板体验】(原创)4.FPGA的GPMC通信(ARM)EDMA

手机:15817255623

手机:15817255623  邮箱:admin@zghxzs.com

邮箱:admin@zghxzs.com  传真:+15817255623

传真:+15817255623  地址:江苏省常州市新北区创业路16号粤海工业园3C

地址:江苏省常州市新北区创业路16号粤海工业园3C